-

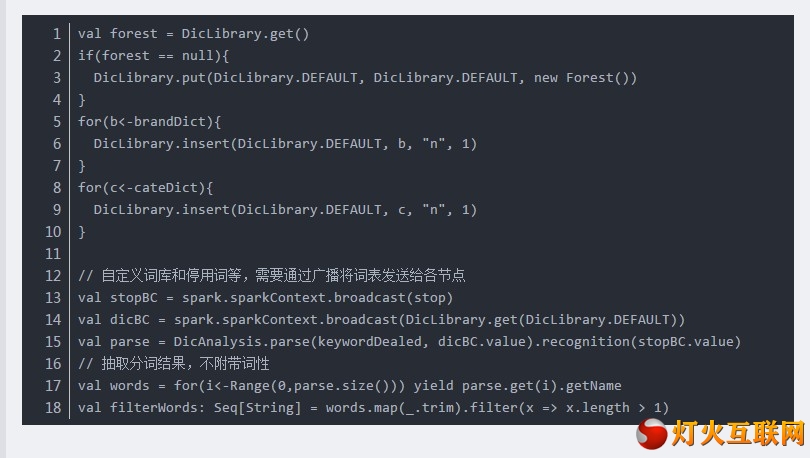

一、Ansj1、利用DicAnalysis可以自定义词库: 2、但是自定义词库存在局限性,导致有些情况无效:比如:“不好用“的正常分词结果:“不好,用”。 (1)当自定义词库”好用“时,词库无效,分词结果不变。(2)当自定义词库“不好用”时,分词... 全文

2019-06-21 13:59 来自版块 - 网络技术

-

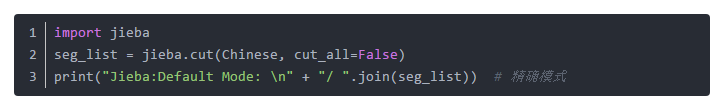

分词工具的选择: 现在对于中文分词,分词工具有很多种,比如说:jieba分词、thulac、SnowNLP等。在这篇文档中,笔者使用的jieba分词,并且基于python3环境,选择jieba分词的理由是其比较简单易学,容易上手,并且分词效果还很不错。 分词前的准备:待分词的中... 全文

2019-06-19 10:34 来自版块 - 网络技术

-

本文是整理了部分网友在配置hanlp自定义词典时遇到的一小部分问题,同时针对这些问题,也提供另一些解决的方案以及思路。这里分享给大家学习参考。要使用hanlp加载自定义词典可以通过修改配置文件hanlp.properties来实现。要注意的点是: 1.root根路径的配置: ha... 全文

2019-06-17 10:16 来自版块 - 网络技术

-

最近发现一个很勤快的大神在分享他的一些实操经验,看了一些他自己关于hanlp方面的文章,写的挺好的!转载过来分享给大家!以下为分享原文(无意义的内容已经做了删除)如下图所示,HanLP的分类模块中单独封装了适用分类的分词器,当然这些分词器都是对HanLP提供的分词器的封装。分类模... 全文

2019-06-14 11:02 来自版块 - 网络技术

-

概述 本文都是基于elasticsearch安装教程 中的elasticsearch安装目录(/opt/environment/elasticsearch-6.4.0)为范例环境准备·全新最小化安装的centos 7.5·elasticsearch 6.4.0认识中文分词器... 全文

2019-06-12 10:25 来自版块 - 网络技术

-

今天介绍的内容是最短路径分词。最近换回了thinkpad x1,原因是mac的13.3寸的屏幕看代码实在是不方便,也可能是人老了吧,^_^。等把HanLP词法分析介绍结束后,还是会换回macbook pro的。个人有强迫症,只要看或写Java或C/C++代码或者用开发机的化,还是... 全文

2019-06-05 11:16 来自版块 - 网络技术

-

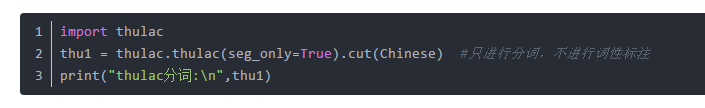

一.中文分词 二.准确率评测:THULAC:与代表性分词软件的性能对比我们选择LTP-3.2.0 、ICTCLAS(2015版) 、jieba(C++版)等国内具代表性的分词软件与THULAC做性能比较。我们选择Windows作为测试环境,根据第二届国际汉语分... 全文

2019-06-03 10:53 来自版块 - 网络技术

-

一、中文分词工具(1)Jieba (2)snowNLP分词工具 (3)thulac分词工具 (4)pynlpir 分词工具(5)StanfordCoreNLP分词工具1.from stanfo... 全文

2019-05-31 11:31 来自版块 - 网络技术

-

以下分词工具均能在Python环境中直接调用(排名不分先后)。1、jieba(结巴分词) 免费使用2、HanLP(汉语言处理包) 免费使用3、SnowNLP(中文的类库) 免费使用4、FoolNLTK(中文处理工具包) 免费使用5、Jiagu(甲骨NLP) 免费使用6、pyltp... 全文

2019-05-29 09:55 来自版块 - 网络技术

-

在进行文本分类(非情感分类)时,我们经常只保留实词(名、动、形)等词,为了文本分类的分词方便,HanLP专门提供了实词分词器类NotionalTokenizer,同时在分类数据集加载处理时,默认使用了NotionalTokenizer分词器。在HanLPJava版代码库中可以查看... 全文

2019-05-27 10:36 来自版块 - 网络技术

2019-05-24 10:46 来自版块 - 网络技术

-

停用词表的修改停用词表在“pyhanlp\static\data\dictionary”路径下的“stopwords.txt”文件中,CoreStopWordDictionary.apply方法支持去除停用词。如果需要修改停用词表,则直接编辑文件“stopwords.txt”,之... 全文

2019-05-22 11:25 来自版块 - 网络技术

-

关于hanlp的文章已经分享过很多,似乎好像大部分以理论性的居多。最近有在整理一些hanlp应用项目中的文章,待整理完成后会陆续分享出来。本篇分享的依然是由baiziyu 分享的一篇文章,感兴趣的可以在知乎上关注下他的专栏,写的还是挺好的!以下为文章的主要内容:自定义词表的修改自... 全文

2019-05-20 10:12 来自版块 - 网络技术

-

Pyhanlp分词与词性标注的相关内容记得此前是有分享过的。可能时间太久记不太清楚了。以下文章是分享自“baiziyu”所写(小部分内容有修改),供大家学习参考之用。简介pyhanlp是HanLP的Python接口。因此后续所有关于pyhanlp的文章中也会写成HanLP。Han... 全文

2019-05-18 10:28 来自版块 - 网络技术

2019-05-17 10:07 来自版块 - 网络技术

-

中文分词是中文文本处理的一个基础步骤,也是中文人机自然语言交互的基础模块。不同于英文的是,中文句子中没有词的界限,因此在进行中文自然语言处理时,通常需要先进行分词,分词效果将直接影响词性、句法树等模块的效果。当然分词只是一个工具,场景不同,要求也不同。在人机自然语言交互中,成熟的... 全文

2019-05-13 10:17 来自版块 - 网络技术

-

HanLP 1.7.3 发布了。HanLP 是由一系列模型与算法组成的 Java 工具包,目标是普及自然语言处理在生产环境中的应用。HanLP 具备功能完善、性能高效、架构清晰、语料时新、可自定义的特点。 在提供丰富功能的同时,HanLP 内部模块坚持低耦合、模型坚持惰性加载、服... 全文

2019-05-10 10:34 来自版块 - 网络技术

-

HanLP分词,如README中所说,如果没有特殊需求,可以通过maven配置,如果要添加自定义词典,需要下载“依赖jar包和用户字典".分享某大神的示例经验:是直接"java xf hanlp-1.6.8-sources.jar" 解压源码,把源码... 全文

2019-05-08 10:04 来自版块 - 网络技术

-

使用 HanLP - 汉语言处理包 来处理,他能处理很多事情,如分词、调用分词器、命名实体识别、人名识别、地名识别、词性识别、篇章理解、关键词提取、简繁拼音转换、拼音转换、根据输入智能推荐、自定义分词器 全文

2019-05-06 10:50 来自版块 - 网络技术

-

1. 整体思路第一步:先将中文文本进行分词,这里使用的HanLP-汉语言处理包进行中文文本分词。第二步:使用停用词表,去除分好的词中的停用词。2. 中文文本分词环境配置使用的HanLP-汉语言处理包进行中文文本分词。·HanLP-汉语言处理包下载,可以去github上下载·... 全文

2019-04-30 09:32 来自版块 - 网络技术